Me propuse escribir un post sobre qué es la información y qué es la entropía. A ver si sale

Una taza de café está formada por un número enorme de moléculas. La mayoría son de agua, pero también hay esencias, celulosa y azúcar. Si quisiéramos describir completamente lo que pasa en ella, tendríamos que conocer la posición y la velocidad de cada una de esas moléculas.

Ese conocimiento nos daría el estado de la taza de café. Por supuesto, las posiciones y velocidades de cada una de las moléculas cambian muy rápidamente. La taza va de un estado a otro con rapidez. Algunos estados se repiten al poco tiempo, otros casi nunca. Cuando las moléculas vuelven a tener casi las mismas posiciones y velocidades cada poco tiempo, se habla de un estado muy probable. Cuando, en cambio, casi nunca tienen esas posiciones y velocidades, el estado es poco probable.

Por ejemplo, los estados donde la crema no está mezclada con el café son muy poco probables. El sistema podría eventualmente volver espontáneamente a uno de ellos, la crema separándose por sí sola del café, pero tardaría muchísimo tiempo. En cambio, los estados con la crema disuelta en toda la taza son mucho más probables, el sistema los recorre asiduamente.

Si nos tomáramos el trabajo de ver las posiciones y velocidades cada una de las moléculas del café en un dado momento ¿cuánto aprenderíamos? ¿Hay alguna manera de cuantificar la cantidad de información que ganaríamos si supiéramos completamente el estado? Si encontráramos un estado muy probable, no aprenderíamos nada que no hubiéramos podido imaginar de antemano. No nos sorprendería encontrar la crema disuelta en el café. Si en cambio encontráramos un estado muy poco probable, aprenderíamos mucho. Si la crema se separó ¡sorpresa!

Es decir que la información que ganamos al mirar una por una las posiciones y velocidades de las moléculas del café, es mayor cuanto menos frecuentes son esas posiciones y velocidades, es decir cuanto menor es la probabilidad. La información crece cuando la probabilidad decrece.

Esta idea de cuantificar la información que ganamos al inspeccionar en detalle un dado objeto, constituye la base de la Teoría de la Información y es extremadamente útil en física. Tanto que existe el llamado programa de Wheeler que intenta reformular toda la física en base a ella.

Uno podría mirar en detalle las moléculas del café repetidamente... Algunas veces aprenderá mucho, ganará mucha información. Otras veces encontrará un estado muy probable, y ganará poca información. Una pregunta natural es ¿cuanta información ganaríamos en promedio? La información que ganamos en promedio al mirar en detalle el sistema repetidamente, es una buena medida de cuánto esperamos aprender la próxima vez que lo hagamos. O sea, nos dice cuánto desconocemos a priori acerca de lo que pasa él. Esa información promedio se llama entropía.

Con esta definición de entropía como información ganada en promedio, la segunda ley de la termodinámica se vuelve sencilla de entender: la entropía nunca disminuye. Pues por supuesto que no: aprenderíamos menos al mirar un sistema ¡sólo si hubiéramos ganado conocimiento a priori sobre él sin haberlo mirado! Más aún: para que la entropía aumente, tenemos que, de alguna manera, perder información. Esto sólo sería posible si, por ejemplo, fuéramos capaces de ver las moléculas de café, pero no las de agua. La información que pierden las moléculas visibles, se esconde en las invisibles.

La entropía y la teoría de la información son hoy un campo muy activo de investigación en física teórica a nivel mundial. Nuestro país tiene investigadores destacadísimos y mundialmente premiados en el área.

Así que ya tienen en qué pensar mientras revuelven el café

¿La pérdida de calor es entropía?

ResponderBorrarEl calor es energía. La pérdida de calor, como cualquier proceso espontaneo, aumenta la entropía.

ResponderBorrarCopyrght disclaimer: mis posts se publican en

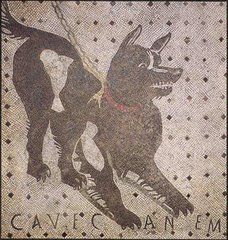

ResponderBorrarCave Canem (ciencia, opinión)

Literatops (literatura, citas literarias)

Diaspora*

Mastodon

SteemIt

Reddit

Facebook

Telegram

También me pueden contactar en

CuriousCat

e-mail